百度搜索官方robots.txt生成检测工作

Robots是站点与spider沟通的重要渠道,站点通过robots文件声明本网站中不想被搜索引擎收录的部分或者指定搜索引擎只收录特定的部分。

9月11日,百度搜索引擎推出了全新的水平.升级后的机器人将优化网站视频URL状态的捕获。仅当站点包含不希望包含在视频搜索引擎项目中的内容时,才使用robots.txt。

如果您希望搜索引擎抓取站点上的所有内容--例如,如果您的网站没有机器人协议,百度搜索将包括视频播放页面的URL、页面中的视频文件、视频周边文本和其他信息,搜索已记录的短视频资源将以视频极速度呈现给用户。

使用百度搜索官方robots.txt生成检测工作,需要登陆到百度搜索资源工具,验证并管理你的网站信息,即可检则自己 网站的ROBOTS.TXT文件情况是否正常。

工具优势,

①可检查自己网站的ROBOTS.TXT是否正常

②可校验自己网站的各个栏目是否能被搜索引擎抓取,ROBOTS.TXT是否正常

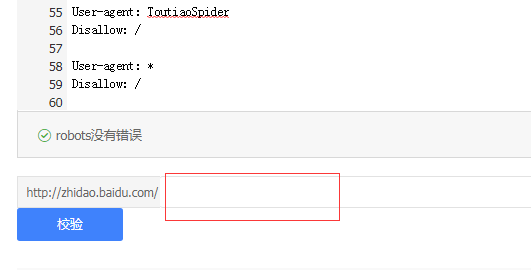

如:百度知道的 zhidao.baidu.com 检则与校验

User-agent: Baiduspider

Disallow: /w?

Disallow: /search?word=

Allow: /

User-agent: Googlebot

Allow: /

User-agent: Googlebot-Mobile

Allow: /

User-agent: MSNBot

Allow: /

User-agent: Baiduspider-image

Allow: /

User-agent: YoudaoBot

Allow: /

User-agent: Sogou web spider

Allow: /

User-agent: Sogou inst spider

Allow: /

User-agent: Sogou spider2

Allow: /

User-agent: Sogou blog

Allow: /

User-agent: Sogou News Spider

Allow: /

User-agent: Sogou Orion spider

Allow: /

User-agent: ChinasoSpider

Allow: /

User-agent: Sosospider

Allow: /

User-agent: YYspider

Allow: /

User-agent: yisouspider

Allow: /

User-agent: EasouSpider

Allow: /

User-agent: ToutiaoSpider

Disallow: /

User-agent: *

Disallow: /

登陆后可见使用链接地址: